Apache Airflow es una herramienta poderosa y flexible para la orquestación de flujos de trabajo, muy utilizada en la gestión de datos y automatización de procesos. En este artículo, exploraremos qué es Apache Airflow, su arquitectura, características, casos de uso y mejores prácticas para su implementación.

¿Qué es Apache Airflow?

Apache Airflow es un sistema de gestión de flujos de trabajo de código abierto que permite a los usuarios programar, monitorizar y gestionar flujos de trabajo complejos. Su principal ventaja radica en la capacidad de definir flujos de trabajo como gráficos acíclicos dirigidos (DAGs), lo que permite una visualización clara de las dependencias y la ejecución de tareas.

Historia de Apache Airflow

Airflow fue creado en 2014 por Airbnb, inicialmente para gestionar sus flujos de trabajo internos. En 2015, se convirtió en un proyecto de código abierto, y en 2016 fue acogido por la Apache Software Foundation como un proyecto incubador. Desde entonces, ha crecido significativamente, convirtiéndose en una herramienta esencial para empresas en diversas industrias.

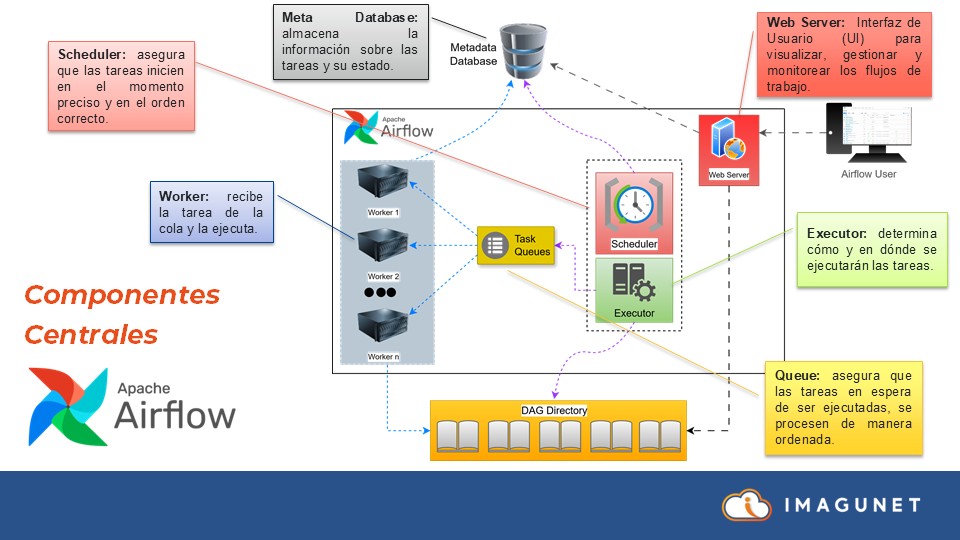

Arquitectura de Apache Airflow

La arquitectura de Apache Airflow se compone de varios componentes clave que trabajan juntos para facilitar la orquestación de flujos de trabajo:

- Web Server: Proporciona la interfaz gráfica donde los usuarios interactúan con los flujos de trabajo.

- Scheduler: Se encarga de planificar las tareas ejecutadas por los usuarios.

- Executor: Ejecuta las tareas y las envía a una cola específica para su gestión.

- Queue: Organiza y gestiona la ejecución de las tareas dentro de un DAG.

- Workers: Son los procesos que ejecutan las tareas definidas en el flujo de trabajo.

- Metastore Database: Almacena todos los metadatos relacionados con las tareas y flujos de trabajo.

Componentes de la Arquitectura:

Cada uno de estos componentes tiene funciones específicas que permiten un funcionamiento eficiente del sistema. Por ejemplo, el Scheduler es responsable de determinar cuándo ejecutar las tareas, mientras que los Workers ejecutan las tareas en sí. Esta separación de roles permite que Airflow maneje flujos de trabajo complejos de manera efectiva.

Características Clave de Apache Airflow

Airflow ofrece varias características que lo hacen destacar en el ámbito de la orquestación de flujos de trabajo:

- Automatización: Permite la automatización de procesos repetitivos y la programación de tareas de forma sencilla.

- Escalabilidad: Puede ejecutarse en clústeres distribuidos, permitiendo manejar grandes volúmenes de datos.

- Flexibilidad: Se integra con una amplia variedad de sistemas y tecnologías, desde bases de datos hasta servicios en la nube.

- Visibilidad: Proporciona una interfaz de usuario intuitiva para monitorizar el estado de las tareas en tiempo real.

Conceptos Clave en Apache Airflow

Para utilizar Apache Airflow de manera efectiva, es esencial comprender algunos conceptos clave, como el DAG. Un DAG es una representación de un flujo de trabajo donde las tareas están organizadas en un orden específico y no admiten ciclos, evitando así bucles infinitos.

Tareas y operaciones

Dentro de un DAG, cada tarea representa una unidad de ejecución que puede realizar diversas acciones, como ejecutar un script de Python o mover datos entre sistemas. Los operadores son componentes fundamentales que definen cómo se ejecutan estas tareas y pueden ser personalizados según las necesidades del usuario.

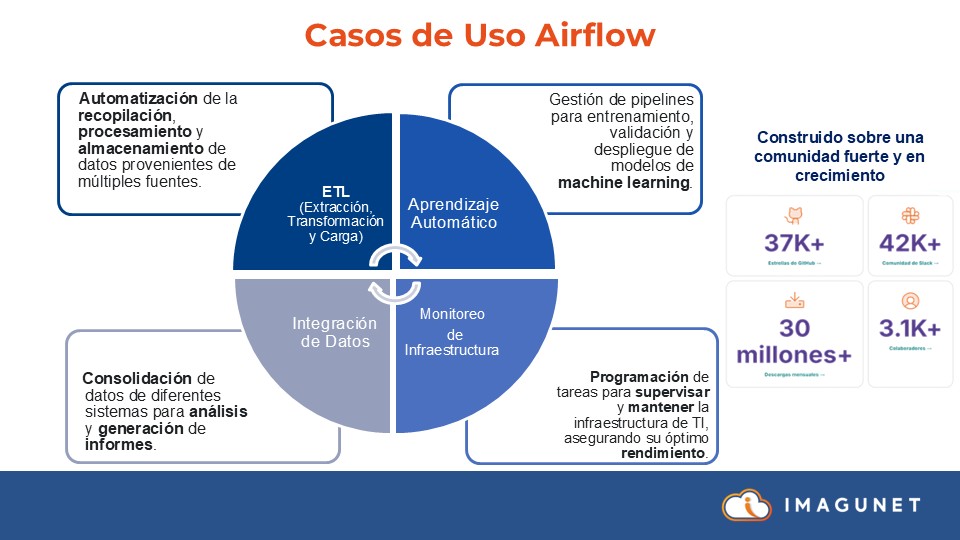

Casos de Uso de Apache Airflow

Airflow tiene múltiples aplicaciones en diversas industrias. A continuación, se presentan algunos de los casos de uso más comunes:

- ETL (Extracción, Transformación y Carga): Utilizado para sincronizar y actualizar datos desde diferentes fuentes.

- Aprendizaje Automático: Facilita la integración de datos para modelos de machine learning, permitiendo la gestión de datos en tiempo real.

- Monitoreo de Infraestructura: Ayuda a supervisar y mantener la infraestructura de TI, generando reportes y alertas automáticas.

- Integración de Datos: Permite consolidar y analizar datos de múltiples fuentes para la toma de decisiones estratégicas.

Ejemplos de Aplicación en Sectores Específicos

En el sector bancario, Apache Airflow se utiliza para generar reportes regulatorios automáticamente y para la orquestación de flujos de análisis de riesgo. En telecomunicaciones, ayuda en la conciliación de datos y la generación de reportes para cumplir con regulaciones. En el ámbito del marketing, permite personalizar campañas basadas en el comportamiento de los usuarios a partir de datos analizados.

Mejores Prácticas para Implementar Apache Airflow

Implementar Apache Airflow de manera efectiva requiere seguir algunas mejores prácticas:

- Configuración de Retried: Establecer un número de reintentos para tareas fallidas puede aumentar la confiabilidad del sistema.

- Optimización de Tareas: Agrupar tareas relacionadas y definir prioridades puede mejorar el rendimiento general del sistema.

- Uso de Sensores: Implementar sensores para esperar condiciones específicas antes de continuar con la ejecución de tareas puede evitar errores.

- Documentación y Versionado: Mantener una buena documentación y utilizar control de versiones para los DAGs ayuda a gestionar cambios y errores de manera eficiente.

Conclusión

Apache Airflow es una herramienta poderosa para la orquestación de flujos de trabajo, que permite a los usuarios gestionar y automatizar procesos complejos de manera eficiente. Su flexibilidad, escalabilidad y la capacidad de integración con diversas tecnologías lo convierten en una elección ideal para empresas que buscan optimizar sus operaciones de datos. Al seguir las mejores prácticas y comprender sus componentes clave, las organizaciones pueden aprovechar al máximo esta herramienta de código abierto.

Más información

Si quieres profundizar sobre este tema, te invitamos a ver la grabación de nuestro webinar, donde exploramos cómo Apache Airflow se ha convertido en una herramienta esencial para gestionar y programar flujos de trabajo de manera eficiente.

🔗 Apache Airflow: Orquestación de flujos de trabajo simplificada

También te puede interesar:

- Descubre las novedades de GLPI 11

- Zabbix Conference Latam 2025: Una experiencia inolvidable para la comunidad de monitoreo en Latinoamérica

- La evolución del monitoreo de redes para ISPs: Zabbix como palanca estratégica para su negocio

- Imagunet: El Primer Partner Gold de GLPI en Colombia y LATAM

- Apache Airflow: Orquestación de flujos de trabajo simplificada